Am 4. und 5. Mai 2020 fand der diesjährige KIM-Workshop (KIM steht für Kompetenzzentrum Interoperable Metadaten) statt. Aus gegebenem Anlass wurde der Workshop mit einem abgespeckten Programm virtuell abgehalten.

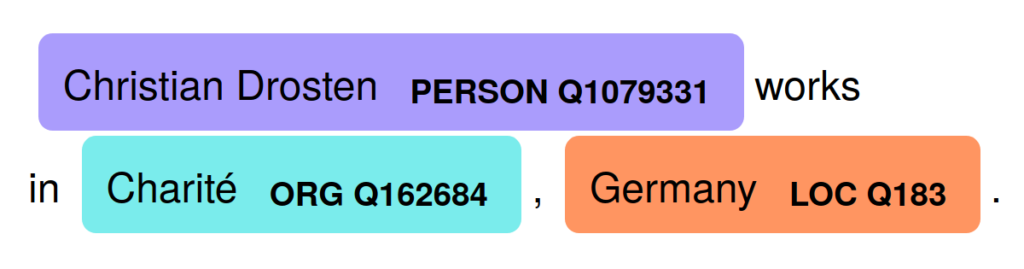

Mit BERD@BW waren wir in der Session “Daten aus Kultur und Wissenschaft in Wikibase” mit einem Vortrag unter dem Titel “BERD mit Wikibase: Instanzierung einer Wirtschaftsontologie im Wikiversum” mit dabei. In unserem Vortrag haben wir erläutert, warum und wie wir die Wikibase-Software für die Ontologieentwicklung und im Frontend einsetzen. Die Ontologie soll Firmen und deren Identifikatoren inklusive deren Quelle und Gültigkeit, sowie bestimmte Beziehungen zwischen den Firmen darstellen. Aufgrund der einfachen Handhabung mit Referenzen, Änderungsverlauf und mehrsprachigen Elementen fiel die Wahl auf Wikibase als geeignetes Werkzeug für unsere Anforderungen. Die Datenabfrage funktioniert u.a. über ein Frontend, welches wir mittels der Flask-Bibliothek in Python über die SPARQL-Schnittstelle von Wikibase implementiert haben. Erste Tests zeigen, dass Wikibase und Python, die über einen SPARQL-Endpunkt verbunden sind, für relativ kleine Datenbanken auch bei vielen Werten pro Eigenschaft eine gute Performance aufweisen. Es sind jedoch weitere Tests erforderlich, um die Performance der Datenbank und des Frontends umfassend zu klären.

In der Session gab es zwei weitere Vorträge zu Anwendungen der Wikibase. Sarah Hartmann und Hans-Jürgen Becker von der Deutschen Nationalbibliothek berichteten von ihrer Evaluation der Wikibase-Software für die GND-Daten. Alan Riedel und Johannes Sperling von der SLUB Dresden testen Wikibase dagegen als mögliches Tool, das Forschenden die Ontologie-Erstellung erleichtern könnte und Datenabfragen sowie -visualisierung ermöglicht.

Zum Abschluss des Workshops bildete sich eine Interessengruppe aus den KIM-Workshop-Teilnehmern, die zukünftig regelmäßig Erfahrungen in der Anwendung mit Wikibase austauschen wollen. Weitere Interessenten sind natürlich gerne willkommen.